前回は、電子楽器の歴史を追ってMoogシンセサイザーまで軽く紹介しました。今回からは、主な電子音源の原理を解説していきますが、まずはアナログとデジタルの違いについておさらいしておきます。

電子技術はアナログ回路からスタートし、デジタル技術が一般化していくのは1970年代後半からです。Moogシンセサイザーが登場したのは1964年なので、デジタル技術は楽器に応用できる段階ではありませんでした。そのため当時は普通にシンセサイザーと呼ばれていました。デジタルが当たり前の現在から見ると、この当時のシンセサイザーは、アナログ回路100%なので、あえてデジタルでないことを強調して、アナログシンセと呼びたくなったわけです。

アナログシンセはアナログ回路で音が作られる

アナログシンセは、音がアナログ回路で作られていることを意味します。アナログ回路を構成する部品は写真のようなトランジスタ、オペアンプ、コイル、コンデンサ、抵抗などの汎用部品です。オペアンプは内部にトランジスタを複数使った便利回路のパッケージです。注意点としては、あくまでも回路がアナログだということです。

アナログ回路で作られた音声信号は、時間軸もレベルも連続的な波形になります。また電気信号は光速で伝わりますから、どんな複雑な回路でも瞬時に反応する利点があります。これがアナログの最大の特徴と言えると思います。電気回路としては当たり前ですが、デジタル回路ではこれができません。

アナログ回路の問題としては、ノイズに弱く、処理ごとに音が劣化したり、コンパクト化が困難、部品もたくさん必要で高価になってしまうなどです。安価に小型高機能化するにはアナログは不向きで、デジタルに置き換えられていきました。

デジタル回路

デジタル回路による音声信号は連続的ではない離散的な信号を扱い、情報は2進数(例 5V=1、0V=0)でやりとりします。時間軸も信号レベルも連続的ではなく、一定時間ごとに階段状に表現されます。そのためデジタルは、どうしても解像度というものが存在します。音の場合は、人間が不自然に思わないぐらいの解像度を使います。なぜそのような面倒なことをするかというと、音そのものを扱うのではなく、数値に置き換えて扱うことで、劣化することなく正確に伝えたり、処理することができるからです。

例としてはCDがサンプリング周波数44.1kHzで、時間の扱いは1/44,100秒単位です。つまり、サンプルとサンプルの間の音声は欠落することになります。またボリュームに相当する音の大小の扱いは16bit(96dB)で、-1〜1を65,536段階で表します。これも本来の音は四捨五入されて、近いビットのところに落ち着くことになります。欠落はあるけれども音楽鑑賞に使える解像度とされ、CDに採用されました。

下図はCDのスペックで441Hzのサイン波1周期分で、100個のサンプルで1周期分の音を作っているのが分かります。

ちなみに初期のデジタル楽器は20〜30kHz、8ビットと解像度が低く、かなり粗い印象を受けます。CDの半分ぐらいの数値になってしまうと、音楽鑑賞するには不十分でしょう。楽器で低解像度が許されたのは、様々な後処理をしていたからです。

現在は、さらに解像度を上げる方向になっていて、サンプリング周波数は96kHzも珍しくなくなり、ビット数は32bit floatで録音できる機材も出始めています。32bit floatは0から無限大まで扱える魔法のような規格なのですが、これを鵜呑みにすると大変なことになります。解像度としては32bitで、ラベルを貼って0から無限大まで扱えるようにしただけに過ぎません。つまり32bitの4,294,967,296段階をプラスマイナスに割り振っているだけで、0に近いほど解像度が上がるようになっています。近年32bit floatが話題になっていますが、あまり踏み込んだ記事を見かけないので、そのうちコラムで解説したいと思います。

下写真はデジタル回路に不可欠なIC(FM音源)と水晶発振器(銀色部品)です。デジタル回路で使われるICはアナログ回路のオペアンプ等と見た目が似ていますが、水晶発振器による振動数を基準にステップ動作します。最近ではICの中に水晶発振器など様々な部品が詰め込まれているオールインワンタイプも多く存在します。ICチップは複雑な回路を極小サイズにすることができるため、専用チップ化されることも多いです。デジタル化のメリットのひとつが、この集積化にあります。しかし汎用品ではなくなってしまうため、製造が終了してしまうと替えがきかない部品でもあります。

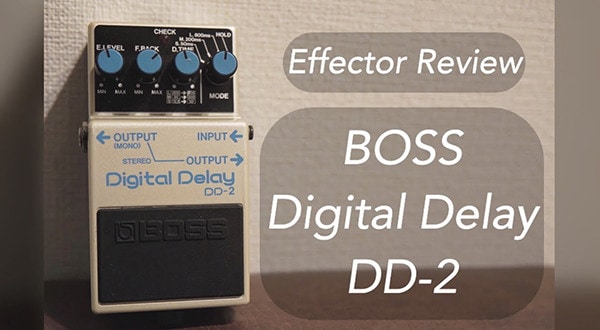

さらに音をリアルタイムで扱う場合、デジタルでは大きな問題を抱えています。デジタル特有の遅延です。デジタルはステップごとに計算しますので、計算量が多いと、どうしても多少の遅延が発生します。リアルタイム演奏でもエミュレート系のエフェクトの利用が流行っていますが、遅延問題は大なり小なりあるので注意したいところです。問題となるのは多少の遅れだと「慣れ」という厄介な現象が起きます。極端な例ですが20msecの遅延をエレキギターのアンプ(アナログ)の位置に例えると、6.8mぐらい離れたところで鳴らす感覚となります。毎日この環境で練習して慣れてしまうと、2msec(0.7m程度)の機材を使ったときに反応が良すぎて戸惑うことになります。以前は、この逆の現象がよく起きていましたが、まさか逆転するとは思いませんでした。いずれにしても遅延は最小限が望ましいのは言うまでもありません。

アナログからデジタルへ

音の解像度や遅延という意味ではアナログは優れていますが、それ以外の欠点から、1980年代に入ると、電子機器の多くは、その利便性からデジタル化されていきます。シンセサイザーも御多分に洩れず、徐々にデジタル化されました。デジタルへの置き換えが可能な部分は、ほとんどデジタル化されたように思います。そのおかげで高品質で低ノイズ、それに手に余るほどの高機能化が実現しました。

しかし2000年以降、その流れと逆行してアナログが復活するというムーブメントが起き、その良さが見直されています。今後は要所要所でアナログの良さを活かす使い方が広まっていくように思います。

アナログとデジタルの違いが何となく理解できたところで、次回は、アナログシンセ(減算式)の音作りの流れを見ていきたいと思います。

コラム「sound&person」は、皆様からの投稿によって成り立っています。

投稿についての詳細はこちら

自分にあったピアノを選ぼう!役立つピアノ用語集

自分にあったピアノを選ぼう!役立つピアノ用語集

各メーカーの鍵盤比較

各メーカーの鍵盤比較

用途で選ぶ!鍵盤楽器の種類

用途で選ぶ!鍵盤楽器の種類

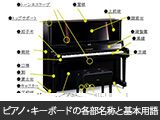

ピアノ・キーボードの各部名称

ピアノ・キーボードの各部名称

キーボードスタートガイド

キーボードスタートガイド

キーボード・ピアノ講座

キーボード・ピアノ講座