コロナ禍もあって生配信、ライブ配信(live streaming)という文化が本格的に音楽の一部として認識されるようになりました。まだまだ草創期と言える時期なのでこれからも変化していくと思いますが、現在のライブ配信の音について少し書こうと思います。

配信はストリーミングと言いますが、ストリーミングってどう言う事? って聞かれると少しふわっとするかもしれません。ライブ配信の音質を語る前に少しファイル再生の歴史と仕様をおさらいしましょう。

1. ダウンロード再生

ストリーミング以外の再生方法といえばダウンロードしたもの、もしくはパソコンなどローカルのデバイスにすでにあるファイルをクリックして再生する方法です。ネット初期はこの方法しかありませんでした。しかし、ファイルの容量が数GB以上あるとダウンロードの時間を待たなければファイルを再生出来ません。また、ファイル容量が大きくなればローカルのHDDやスマホの保存容量をどんどん占有していきます。

2. サーバー上の物をストリーミング再生

そこで登場したのがストリーミング再生という方法です。サーバーにあるファイルをダウンロードしながら再生していくという方式になります。これによってダウンロードの時間を待たずに再生する事ができるようになりました。音声ファイルくらいの軽いファイルならそこまで使用感は変わらないと思いますが、動画サービスに関してはこれがないと成り立ちません。YouTubeの動画をいちいちHDDにダウンロードしてたらやってらんないですよね。

3. ライブストリーミング

そして更にサーバー上に保存したものではなく、リアルタイムで収録したものを生配信するライブストリーミングが出てきました。ほぼテレビの生中継を見るような感覚になっていますし、これから5Gが広まれば動画のクオリティーも上がっていくでしょう。

■ ストリーミング、ライブストリーミングの音質について

こうやって聴くとストリーミング最強、と思うかもしれませんが必ずしもそういう訳ではありません。きっちり、デメリットもあります。メリットはたくさんあるのでここではデメリットを上げていきます。

まず、オフラインで再生する事が出来ない。要するにネットに繋がらないと再生出来ないと言う事です。ネットの繋がらない山奥や地下、通信制限をくらってしまったら音楽も聞く事ができません。普段は気にする事ではないですが当てにしてたのに再生できない状況は結構ストレスですので、頭のどこかに留めておくといいですね。これがデメリット1です。

ここからは特に音楽の配信のお話になります。音楽の配信と言えば色んなサブスクリプションサービスがあってどこが曲が多い、音質がいい等の様々な情報があります。ファイルフォーマットやビットレートは非公表のところが多いですが、総じて言えるのはWAVEデータ等の非圧縮ファイルではないという事です。MP3、AAC等の既存の圧縮ファイルか独自の圧縮方式のファイルでしょう。なぜわかるかと言えば、もしWAVEファイルを配信したら一枚のアルバムを聴くのに500MB前後の容量が必要だからです。Wi-fiのない外で聴いていたらソッコー通信制限くらいますね。実際NetflixやAmazon Primeのオンデマンドの映像コンテンツを見るとしっかり数GBが使用されます。

アーティストはもちろん24bit,48kHz以上のWAVEデータのクオリティーで楽曲を制作しているでしょうから、配信の音質はアーティストがレコーディングしたものから必ず劣化しています。これがデメリット2です。

とは言えこれはMP3の理論上の音質劣化は1割程なのでBGMで流す程度の用途なら気にならないかもしれません。(しかし、僕が聞いているサブスクリプションサービスの音声は自分でCDからMP3にした音源に比べ明らかに音がボケて細く感じました。圧縮音源はファイルをデコードする再生アプリにも音質が左右されるので注意は必要です。)

■ ライブストリーミングの音質

ライブストリーミングといえば現在ほぼ動画付きですので、ラジオのような音声のみのライブ配信の事は今回は割愛します。

少し動画のフォーマットやコーデックの話もしなければいけません。基本的に配信の動画はMP4で作られます。これをMA現場ではおなじみの(一般の人にはおなじみでない)H.264のコーデックを使って圧縮データとしてストリーミングします。フレームレートなんかの細かい映像ファイルの話は割愛しますが、色んな仕様が選択できるのが通常です。

さて、MP4で映像と一緒に使われる音声はAACかMP3になります。サンプルレートは44.1kHz,ビットレートは128kbpsが推奨されている事が多いです。音楽ライブの配信などではビットレートが192kbps~384kbpsにして高音質を謳っている事もあります。しかし、384kbpsになると現在のネット通信環境では試聴が厳しいユーザーも出てくるのではないかと思います。こういう高温質を売りにした配信の場合、現状データ量が重いので早い回線を推奨するという注意喚起も必要です。

一般的にWAVEデータ(CD)をMP3に変換する時に推奨されているのが192Kbpsくらいなので配信の音質はそれでも特別高音質というわけでもないです。

そして、さらにライブ配信の場合ダウンロード再生、ストリーミング再生に比べてデータが劣化する過程が多いのでAAC、MP3の音質がそのまま視聴者に伝わる事は少ないと考えていいです。

概してデジタルサウンドは生音に対して劣化との戦いなのですが、ライブストリーミングは現在もっとも過酷な劣化に晒されている音源とも言えます。少し音が視聴者に届くまでの音の流れを追ってみましょう。

生音

↓

マイク、アナログ機器(アナログ回路での劣化)

↓

サンプリング(デジタル化)

↓

圧縮(圧縮による劣化)

↓

パケット通信

↓

デコード(再生アプリごとの若干の音質ムラ)

↓

(視聴環境、デバイスによる劣化)

とこんな具合になります。

ストリーミングサウンドはこんなにもデジタルは劣化の機会に晒されているのです。更にライブストリーミングではRTMP、RTMPT、HLSなどのライブストリーミング用の通信プロトコル(通信方式って事ですw)が使われています。通常のプロトコルによるファイルダウンロードではユーザーからダウンロードのリクエストがあるとデータをパケット化(小さく袋分けするイメージ)し、それぞれ最適な回線を通ってユーザーの元へ届きます。しかし、その途中でパケットが失われて届かない事もあります(パケット欠損)。その場合はもう一度ファイル元にリクエストしてそのパケットを送ってもらう事になります。パケットには順番が振られていますので順番通りに並ばないとデータが崩れてしまいます。その為その再リクエストしたパケットが届くまで次のパケットは待機する事になります。それが何かのトラブルで届かなかったり、ユーザーの回線がプアーで処理が追いつかないと再生が止まったり、ダウンロードの速度が落ちたります。

ライブストリーミングではリアルタイム性が大事ですので一番の避けたい事故は動画が止まる事です。その次に遅延する事です。

従来の通信方式ではこのリスクを避ける事が出来ませんので、RTMP、RTMPT、HLSなどのライブストリーミング用の通信プロトコルを使います。これらのプロトコルでは一定の間隔で同期コードを埋め込む事でこのリスクを回避しています。この同期コードによって前のパケットが欠損して届いてない場合は無視して再生を続ける事が出来ます。もちろんエラー補正のプログラムもあると思うのですが、欠損したパケットはないわけですからデータは劣化します。動画の画像がカクカクしてボケてるような事が音にも起こっていると言う事です。

これがライブストリーミングが通常のストリーミング以上に劣化に晒されている要因です。再生が止まっても全てのデータが届くのであれば音質は元と変わりありません(理論上)。ライブ配信でないストリーミングでもこのRTMPなどのプロトコルを使っていればデータが少し欠損しているでしょう。

こう考えると昨今需要が少なくなったライブDVD(Blu-ray)の仕様は24bit,48kHzほどの音質を提供してくるので、あながち捨てたもんでもないような気がしますね。

■ ライブ配信の音声対策

ライブストリーミングの音声は様々な複雑な要素が絡んでくるので音質を完全にコントロールするのは難しいかもしれません。しかし、配信側がやれる事は至ってシンプルなのではないでしょうか? 最後に列挙してを終わりにしたいと思います。

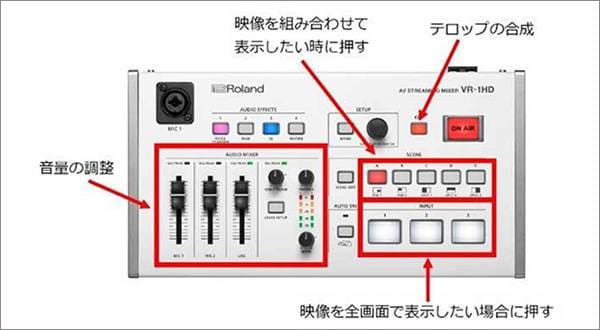

1. まずアナログ回線での劣化をすくなくする。

これはアナログ、デジタル、配信関係なく行うべき事ですね。いいマイク、ミキサー、インターフェイスなどを使いましょう。アナログ領域での劣化が少なくしようとするとやはりお値段も上がってしまいますが、出来るだけ必要なクオリティーを満たすものを選ぶと良いと思います。

2. PCの性能を良くする

スマホだけでも配信が出来ちゃう時代ですが、やっぱり高音質配信でお金を取る、となるとPCでないと安定しないのでPCを使いましょう。PCも絶対Mac Proの最上位である必要はありませんがある程度のメモリとCPUは必要なので一応高性能、と謳われているPCを使えばいいかな、と思います。ラップトップのPCでもUSBなどで接続して他機材との拡張性を上げるためにUSBポートなどの数は確認した方がいいです。Wi-fi接続できる機器も多いですが可能な限りおすすめしません。故障リスクの管理が増えるのと安定性の問題を考えるとやはり有線の方がおすすめです。ライブは安全第一です。

3. フォーマットの適切な設定

先にも述べた通り、配信のビットレートをあげれば音質を上げる事が出来ますが回線、デバイスの負担は増えます。適切なフォーマットとクオリティーを模索し設定する事です。

4. できるだけ早く安定した回線と契約し、使用する配信サービスが十分なサーバーを使用しているか検討する。

これは当然なんですが出来るだけ早く、安定した回線からデータを送り出す事でデータ欠損による音質劣化の機会を減らす事が出来ます。また、どれくらいの視聴者が集まるのか、それによって必要なサーバー規模も違ってきます。無駄に大きくする必要もないですし、しょぼいとアクセスが集中して事故の元になります。使用する配信サービスをしっかり検討しましょう。YouTube等のライブ配信だとあまり考える必要はないですが、主に独自のライブ配信サービスを使う場合です。また、AmazonのクラウドサービスAWSではAWS Elemental Linkという製品を発表しています。これはサーバー転送に動画の品質等を最適化し、放送局並みの安定性を保証してくれる商品です。このような商品を使えば個人でも最適な環境を使えるかもしれませんが、でもこれはプロ向けでしょうね。

5. 適切な視聴環境の喚起

どんなに送信側で万全なクオリティーでも受け手側の環境とミスマッチしては高品質な物を届ける事はできません。やっぱりライブの音声をPCやスマホのしょぼいスピーカーで聴くのは違う気がします。ヘッドフォンやイヤホン、そこそこのスピーカー(せめてテレビくらい)で聴く事を推奨してもいいかもしれません。また必要な回線速度も喚起しておくべきでしょう。せっかくお金払ったのに自分の回線の環境のせいで聴けなかったという事を避け、可能な限りいいユーザー体験を得られるように啓蒙するのも配信側がやるべき大事な事の一つでしょう。

ライブストリーミングはこれからも重要な活動方法の一つになると思いますが、配信のサウンドの正体を知る事で少しでも音質向上につながればと思います。

コラム「sound&person」は、皆様からの投稿によって成り立っています。

投稿についての詳細はこちら

![[2024年]オススメの配信機材15選!ライブ配信・ゲーム実況・ポッドキャストを始めてみよう!](/contents/uploads/thumbs/2/2021/12/20211214_2_15561_1.jpg)

ライブ配信に必要な機材

ライブ配信に必要な機材

ライブ配信に必要な機材を徹底解説 オンラインライブの創り方

ライブ配信に必要な機材を徹底解説 オンラインライブの創り方

ミュージックビデオ撮影テクニック!

ミュージックビデオ撮影テクニック!

タイプで選ぶ「良音」カラオケ配信機材

タイプで選ぶ「良音」カラオケ配信機材

配信・ポッドキャスト特集!(ライブ/動画/ゲーム実況)

配信・ポッドキャスト特集!(ライブ/動画/ゲーム実況)

ライブをしよう!

ライブをしよう!