Dolby Atmosは概念を理解し、慣れるまで、かなり苦労するものではあります。

現在、Pro Tools(Ultimate)とAntelope AudioのDolby Atmos対応デバイスで最大のチャンネル数9.1.6で概要を理解していきましょう。

本当は実際にDolby Atmosを体験していただけると理解度が違ってきますので、体験していただけることを推奨致します。

01 Dolby Atmos 9.1.6とは

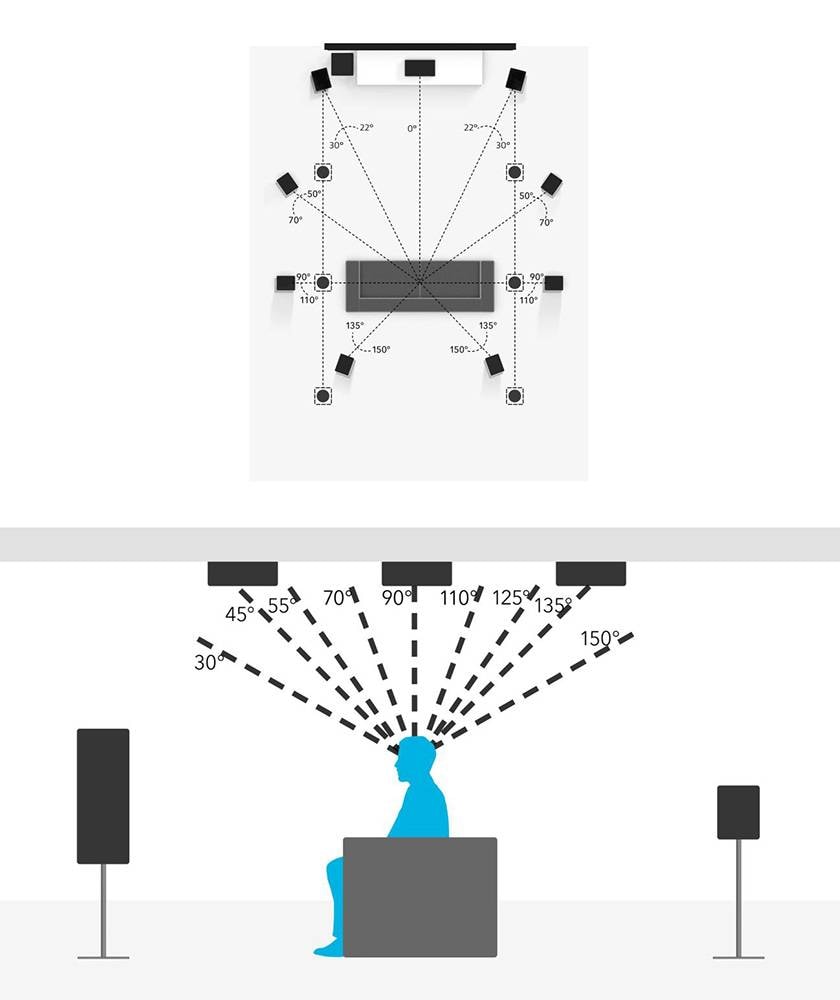

水平方向に9ch+LFE (Sub Woofer)と垂直方向(天井)に6chのスピーカー、合わせて16chのシステムのことを言います。日本で一般的なのは7.1.4chではありますが、16chって音響の世界でちょうどいい数字な気がしますよね。ですから9.1.6で説明していきます。

この9.1.6のスピーカー配置から音が出ることによって、大体半球状の音場空間が形成されます(Dolby AtmosパンナーまたはDolby Atmos Music Pannerプラグインからメタデータとして生成されたX、Y、Z座標)。現状のスタンダードフォーマットの2chと比べると、上と後ろの音も再現できるような配置になります。

音場に包まれるような音が再現されると、そこで音を聞いている人はさらなる没入感と臨場感を味わうことができます。これがDolby Atmosの没入(Immersive)と空間表現(Spatial)の所以です。

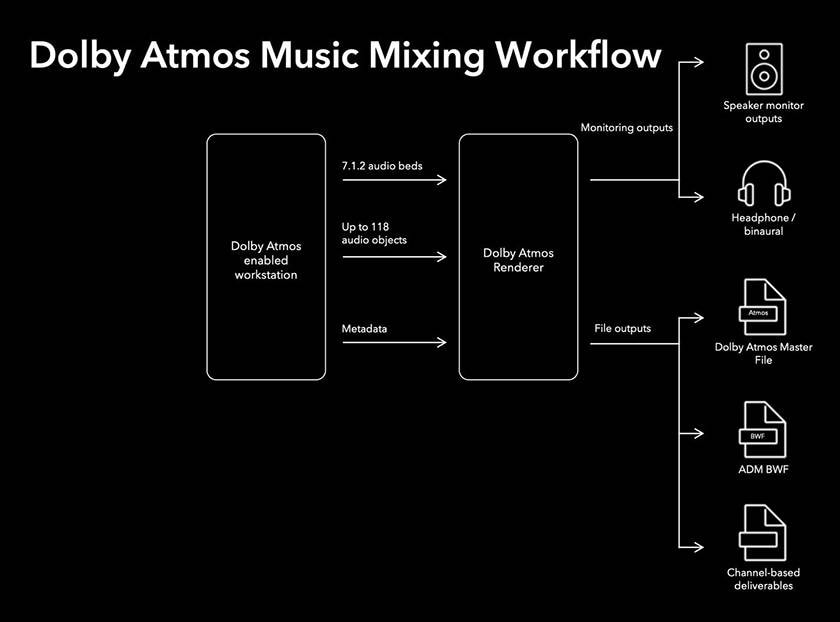

そしてDolby Atmosの再現にはDolby Atmos Rendererというものが必要です。(現状、DAW上での話です)

不思議に思ってください。私たちはApple Musicなどで空間オーディオを聴くときはヘッドフォンまたはイヤフォンで視聴します。にもかかわらず、Dolby Atmosの制作には7.1.4chや9.1.6chなどの、イヤフォンでは到底再生は物理的に不可能なチャンネルを利用します。

しかし、スマートフォンでDolby Atmosは再生可能なのです。この違和感や今までのチャンネル概念の常識の枠から少しはみ出るのが空間オーディオの特徴となります。

02 Dolby Atmos のチャンネル概念

今までの2chステレオ、7.1chなどのサラウンドは「チャンネルベース」という概念で運用されています。これは言葉での理解が難しいですが、ステレオのサウンドはLchとRchの2つの信号がそれぞれLとRのスピーカーに出力される構造です。じつはステレオ音源というのはモノラルのLとRの2つの信号2chでステレオを再現しているのです。

7.1chも同様に7つの信号がそれぞれ割り当てられたスピーカーに出力され、低域はサブウーファーに割り当てられるため、7.1chのコンテンツを2chで再生することは、物理的には可能ですが、7.1chの表現を再現して再生することは不可能になります。

これは「7.1chのコンテンツを視聴したい場合、7.1chの設備が必ず必要になる」という意味で捉えていただいて構いません。

Dolby Atmosにはこの「チャンネルベース」の概念が基本はなく「オブジェクトベース」という概念、考え方をします。

03 オブジェクトベース

横文字が出てくるとちょっと拒否反応があるかもしれませんが、オブジェクトの意味は物体や対象など「像」という概念がある言葉です。

今までのチャンネルベースの考え方は100%スピーカーの数と配置に依存する音の音場表現になります。

エジソンが蓄音機を発明してから約150年、音響の世界ではスピーカーから発せられる音が如何にリアルな音場空間を再現できるか、を挑戦してきました。

その音場空間の再現のために考えられたのが「オブジェクトベース」の考えです。VRでは「シーンベース」という考えの概念もあります。Dolby Atmosは「BedsとObjects」というワークフローの概念を採用しています。

Dolby Atmosのオブジェクトベースの考え方は実はシンプルです。118chのモノラルチャンネルを半円球空間の好きなところに配置することができる、というものです。

今までのチャンネルベースパンの考え方は、各スピーカーの相互関係から音量制御を行い、位置を擬似的に配置するものですが、このオブジェクトベースの考え方はX, Y, Zの3次元の仮想空間上にパン情報をメタデータとして記録するというものです。

ですので、今までは7.1chであれば、物理的に8chのチャンネルが必要でしたが、仮想的な空間上にチャンネルのパン情報がメタデータとして保存されているDolby Atmosは118chの物理的なチャンネルが必要ではなく、118ch分のメタデータを利用してDolby Atmos Rendererが、2.0や5.1や7.1.4、9.1.6のスピーカー配置(チャンネル) に自動的に最適化して再生してくれるというものです。

ちょっと言葉が難しいですが「スピーカーや再生環境には依存しないよ」と思っておけばいいと思います。

04 Beds と Objects

Dolby Atmosの理解が難しいポイントとして、Beds と Objects があります。

運用していく上ではありがたい考え方なのですが、最初の躓きポイントです。

Bedsとは従来のチャンネルベースを想定した最大7.1.2ch、10ch分の固定チャンネルです。Bedsは規格上必ず設定しておく必要があるらしい。

そしてObjectsとは118ch分の自由なオブジェクトベースチャンネルになります。

……そうですよね……よくわかりませんよね。こればかりは実際にDolby Atmosのチャンネルを触って覚えていただくしか無いのですが、ここではBedsは従来のサラウンドと同じで、残る118chのObjectsは自由な移動が可能な音と捉えておきましょう。

感覚としてはインターフェースの物理アウトプットの前に、従来のチャンネルベースの10ch があり、その次にX,Y,Zの仮想空間用の118chが内部バス上にあって、それらを物理アウトプット用に出力変換してくれるのがDolby Atmosです。言葉ではなかなか捉えにくいですが、仮想空間用の内部バス(仮想ドライバと捉えるとわかるかも?) があってそれをDolby Atmos Rendererが各再生環境に合わせてレンダリングしてくれる、というのが現状のDolby Atmosです。

Bedsのグループは従来のスピーカー配置に依存するような形で制作しますが、Objectsの118chはスピーカーに一切依存しません。再生環境が2.0だろうが、5.1、7.1.4、9.1.6であろうが、Dolby Atmos Rendererは選択した再生環境に最適化して再生します。

ですので、Dolby Atmosでの制作時、Bedsのチャンネルをあえて使わず、残りの118chのObjectsを利用して、ヘッドフォンでも自由な配置のDolby Atmosの制作は可能なのです。

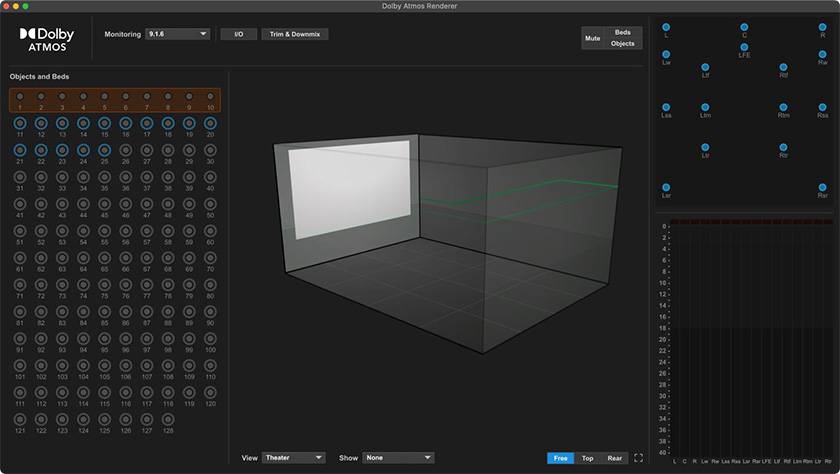

上記画像の左上の赤枠一列がBedsのチャンネルで1-10が選択されています。これは固定ですが、11-128のチャンネルはフリーな状態。青い枠が付いているchは現在利用中のチャンネルで、右側には現在再生中のスピーカー配列が見えます。

2chのダウンミックス状態で再生している時にも緑のObjectsが無尽蔵に動き回ります。

Dolby Atmos Rendererの1-10chはBedsと呼ばれる7.1.2のチャンネルベースに利用され、11-128chの残りのチャンネルは自由な配置を取れるチャンネルになっています。

Bedsのグループは固定配置自体を利用したい音楽などがある場合に役立ちます。従来のチャンネルベースミックスやステムに利用でき、Dolby Atmosのメタデータは所持しません。これはDolby Atmosのミックス中にステレオの音声素材を従来のチャンネルベースで配置したい、サラウンドでミックスしたオーケストラ音源(劇伴)を流用したい場合にBedsのチャンネルを利用すれば、非常に作業としては合理的ですよね。

そしてDolby Atmosの自由な配置は11-128に割り振ったObjectsのチャンネルを操作することで可能になります。(要は DAW上で11-128chの仮想空間用のバスに自由に配置を動かしたい出力を割り当てるだけです。)

このObjectsのチャンネルは X,Y,Zの 3次元のパン情報をメタデータとして保持しているものなので、従来のPanとは異なる情報を持っています。従来のPanは情報を持っているのではなく、各チャンネル間の音量としてデータ内に保持していて、これは音源の書き出しをしてしまえば、あとからPanは変更できません。

今までのチャンネルベース感覚を持ったままDolby Atmosの概要をなんとなくさらっていくと「9.1.6でミックスした音声は7.1.4の環境では再現できない」という感覚に陥りますが、いままでのサラウンドのような空間の配置を16chのチャンネルデータとして扱うわけではなく、Dolby Atmosは音の配置情報を持っているデータを利用してDolby Atmos Rendererが各スピーカー配置に合わせて再生するというものです。

ですので、Dolby Atmosの制作において、じつは大掛かりなシステムは必要ありません。Dolby Atmos Rendererが各環境に自動的に合わせて再生してくれます。

ただし、バイノーラル再生にも限界がありますので、7.1.4~9.1.6のスピーカーを実際に規定通りに配置して制作するスタジオがあるのです。

05 仮想空間Bus(ドライバまたは I/O)という概念

仮想空間Busという名称は筆者が今考えた考え方の名称で正式な名称ではありませんが、Dolby Atmosというのは128chの信号を割り当てることがでるのですが、物理的なOutputsが128chある、という意味ではないのです。

イメージとしてはDAW上で利用する仮想ドライバや仮想I/Oセッティングとほぼ同義です。

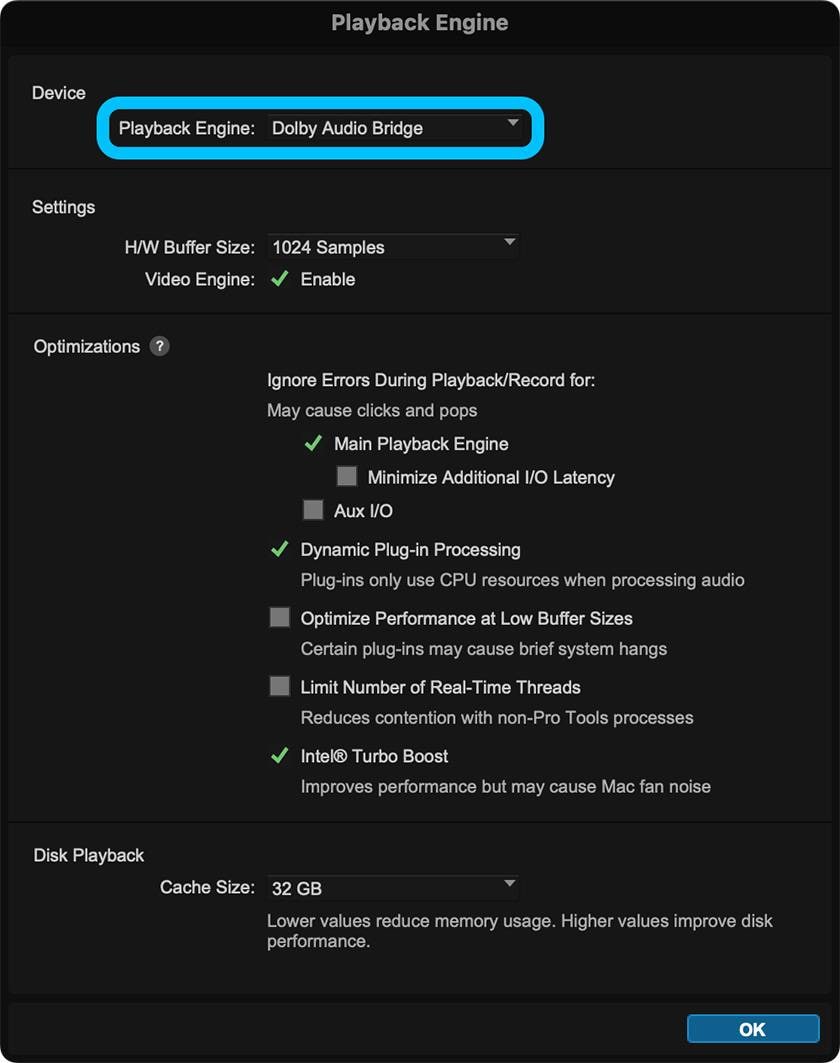

そのため、Pro ToolsでExternal Rendererを利用する際はPlayback Engineを「Dolby Atmos Bridge」という仮想ドライバ(I/O)を選択する必要があります。

仮想空間のバスに送られた信号がDolby Atmos Rendererと繋がり、最終的にDolby Atmos Rendererが任意のオーディオインターフェース、デジタルハードウェアから信号を出力されます。

つまりはDolby Atmos Rendererに信号をDAW上から送っているという状況。

このセッションのプレイバックエンジン(利用しているドライバ、またはI/Oセットアップ)はDolby Atmos Bridgeを利用しており、実際にDAWはオーディオインターフェースなどのデジタルハードウェアと直接通信しているわけでは無いことが理解できます。

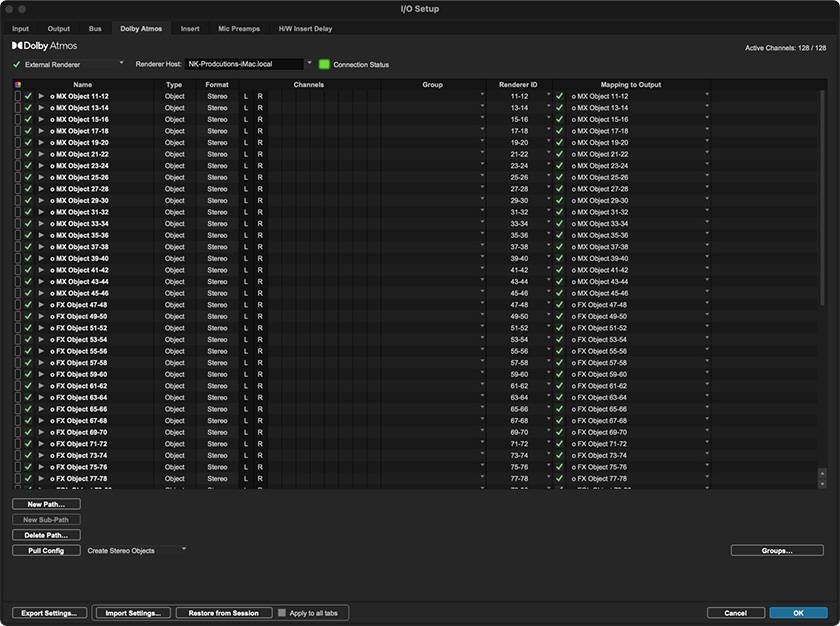

下の画像はとあるDolby Atmosセッションの仮想空間Busの様子。

11~78chのX,Y,Zの仮想空間用のバスを利用している状況で、この11-78chの信号はすべてDolby Atomos Rendererの内部仮想空間用のチャンネルであるため、信号は一旦Dolby Atomos Rendererへ行きます、そのあとDolby Atomos Rendererで設定した出力のオーディオインターフェースへ信号を送ります。

ここでは、11-78chが有効ですが、Dolby Atmosが利用できる128chすべてがDolby Atmos用の内部仮想空間用バスとなります。もちろんBedsは7.1.2のチャンネルベース出力に割り当てられます。

ややこしいですが、Dolby Atmosの環境構築概要はDolby Atomos Rendererへ信号を送ってさらにDolby Atomos Rendererが任意のデジタルオーディオインターフェースへ信号を出力するということです。

だからDolby Atomos RendererがExternalでもInternalでも実装されているDAWであれば、ヘッドフォンでも十分に環境を構築できます。(その場合バイノーラルで再生する)

Binaural(バイノーラル)でモニターすれば、ヘッドフォンでもDolby Atmosのミックスは可能で、現状、視聴者層が7.1.4などの環境を構築することは現実的ではないため、バイノーラルで聴く前提で制作することは非常に理にかなっていると言えます。

コラム「sound&person」は、皆様からの投稿によって成り立っています。

投稿についての詳細はこちら

厳選!人気のおすすめオーディオインターフェイス特集

厳選!人気のおすすめオーディオインターフェイス特集

自宅スタジオの作り方

自宅スタジオの作り方

ANTELOPE AUDIO 特集

ANTELOPE AUDIO 特集

スタジオモニタースピーカーを選ぶ

スタジオモニタースピーカーを選ぶ

機能で選ぶ オーディオインターフェイス

機能で選ぶ オーディオインターフェイス

人気スタジオモニター徹底比較

人気スタジオモニター徹底比較