AI Services Becoming More Accessible and Sound Design

AI services have become deeply integrated into our daily lives. Generative AIs like ChatGPT are being used not only for writing and translation but also for generating programming code, brainstorming ideas for images or music, and much more across various fields.

In the music industry as well, there’s a growing number of cases of having AI write lyrics or asking it to give hints for composition, which suggests that AI may become an essential partner in future production environments.

Throughout all of this, a question suddenly came to mind: “What would happen if we let AI handle guitar tone crafting?” In particular, crafting tones with multi-effects processors can be a daunting task for beginners. If AI could guide me through the process, it would be incredibly reassuring.

So this time, I actually asked ChatGPT to design a tone, and then translated that setting into the BOSS flagship multi-effects processor, the GT-1000.

Target Tone and Equipment Used

The tone I’m aiming for this time is a crunch sound suitable for chord backing that works well in Japanese pop/rock. (Reference track: Vaundy – “Jounetsu”)

If I can recreate a sound that is light and crisp yet still has a solid core, I can consider it a success.

The equipment used is as follows:

Multi-effects processor: BOSS GT-1000

I asked ChatGPT the following question:

Recently, I have found that ChatGPT has become much more convenient—it now understands the intent even when questions are phrased more casually compared to before.

ChatGPT’s Response

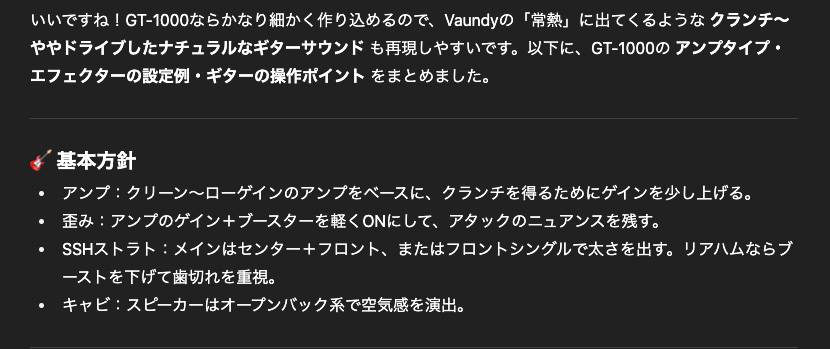

Here is the response from ChatGPT:

First, it suggested elements like the type of amp, how to apply distortion, and pickup selection on the guitar itself. In the second half of the response, it even provided detailed parameter values.

Based on this information, I’ll now move forward with creating the tone using the GT-1000 within the range that can actually be reproduced.

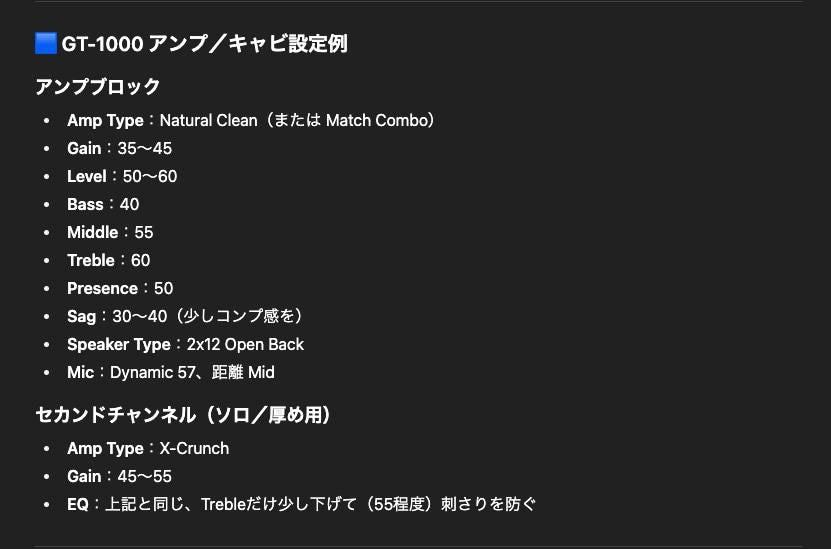

Amp Settings and Key Considerations

First, I started with the amp model settings. The GT-1000 includes a wide variety of amp types, and I selected one of them and adjusted its parameters accordingly. ChatGPT’s response was highly detailed. It not only covers standard settings like Gain, Bass, Middle, Treble, and Presence, but it also addresses GT-1000-specific parameters such as Amp Type and Sag.

However, there was an issue: the suggested “Sag: 30–40” isn’t possible on the GT-1000. Its Sag parameter ranges from -10 to +10, so I approximated it by setting it to +3—about one-tenth of the proposed value.

For the speaker type, I chose the built-in cab simulator:

“2×12*5 (Celestion-loaded open-back)”

When I test-played this setup, the sound was natural and clean. While it still felt lacking compared to the reference track, as a clean tone, it was highly usable—leaving me hopeful for the next steps in the tone-building process.

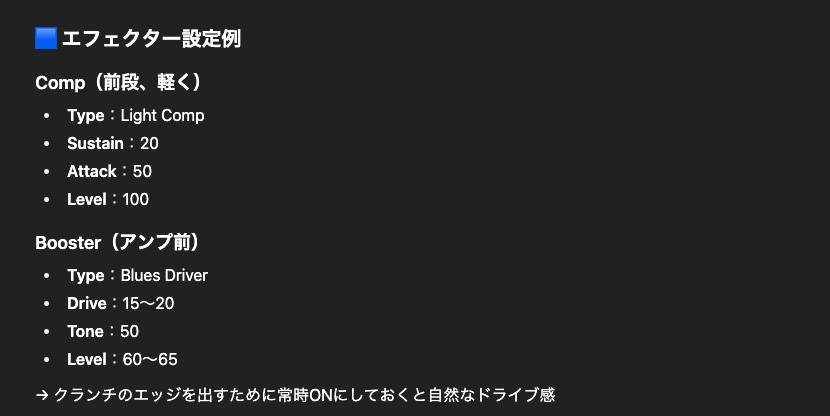

Effect Settings 1: Comp & Drive

Next, I added a compressor and overdrive.

In ChatGPT’s response, the suggested compressor type was “Light Comp”, but since this does not exist in the GT-1000, I substituted it with BOSS COMP. For overdrive, “Blues Driver” was specified, so I used Blues OD from within the GT-1000.

Special attention was needed for the Tone value. ChatGPT specified a value of “50”, but since the GT-1000's range is -50 to +50, I set it to the midpoint, which is 0.

With this configuration, the sound got much closer to the reference track, and delivered a crisp, snappy crunch. However, since spatial effects haven't been added yet, there’s still a lack of width and depth in the overall tone.

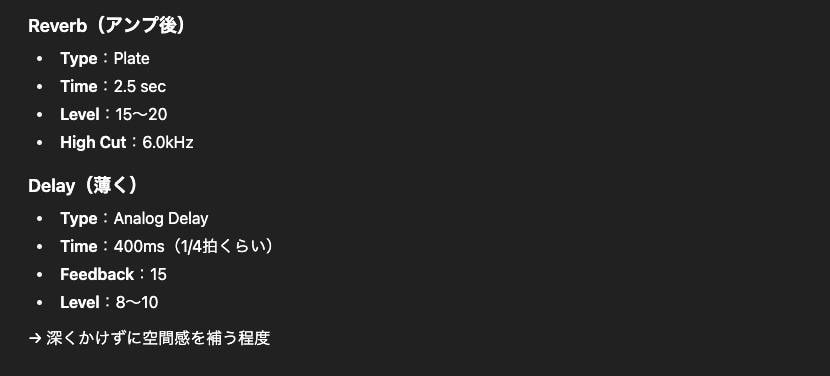

Effect Settings 2: Reverb & Delay

Next, I added spatial effects. ChatGPT specified a High Cut of 6.0 kHz for the reverb, but since the GT-1000 only allows setting it to 6.3 kHz, I used the closest available value. For the other parameters, no specific values were given by ChatGPT, so we kept them at their default settings.

Once reverb and delay were added, the sound gained a sense of space and it felt significantly more complete. However, compared to the reference track, it did come across as slightly too wet. Even so, the fact that such a usable tone could be created entirely from AI suggestions was a major discovery.

Final Adjustments

To finish, I made a few tweaks:

- Switched the pickup from front to front + rear (inner coil tap) to aim for a Telecaster-like half-tone sound.

- Slightly lowered the Presence and Treble in the amp’s EQ settings.

- Reduced the Reverb and Delay Levels to dial back the wetness.

What I Learned from This Experiment

Through this experiment, I especially came away with the following three insights:

- 1. AI suggestions are extremely effective for grasping a direction.

– It gets you closer to your goal more efficiently than starting from scratch. - 2. Parameters and functions don’t match perfectly.

– Adjustments must be made by the player to fit the GT-1000’s unique specs and value ranges. - 3. In the end, it’s the human ear and intuition that complete the tone.

– What AI provides is merely a starting point. The final “good sound” depends on the player’s own sensibility.

Conclusion: Dividing Roles Between AI and Humans

AI can propose ideal settings based on its vast knowledge. However, it can’t fully grasp the subtle equipment differences or what each person perceives as a pleasant sound.

In this experiment, by using ChatGPT’s suggestions as a starting point and then making adjustments by ear, I was able to create a practical and usable tone.

If you're struggling with tone crafting on a multi-effects unit, try consulting AI—it might lead you to new discoveries. It can serve as a valuable guidepost in sound design, especially for beginners.

For more details on the results of this experiment, click here.

The column “sound & person” is made possible by contributions from our readers.

For more information about submitting, click here.

![[For Students] How to Create Compact Pedal Sounds with the ZOOM G3n!! - Overdrive Edition](/contents/uploads/thumbs/5/2023/8/20230821_5_23671_1.jpg)

![[Latest for 2025] The 10 Best Effects Pedals for Guitar Beginners!](/contents/uploads/thumbs/2/2022/5/20220526_2_18129_1.jpg)

![[Beginner-Friendly] Part 1 - Pedalboard Gems: A Slightly Nerdy Effects Pedal Guide: Overdrive Pedals](/contents/uploads/thumbs/2/2016/9/20160909_2_282_1.jpg)

BOSS ブランドページ

BOSS ブランドページ

Ibanez ブランドサイト

Ibanez ブランドサイト

【初心者向け】エフェクター講座

【初心者向け】エフェクター講座

ベース用エフェクターの種類

ベース用エフェクターの種類

エフェクターのつなぎ方

エフェクターのつなぎ方

エフェクターの種類

エフェクターの種類